LoRA

此介面提供了使用 LoRA(低秩適應) 微調大型語言模型 (LLM) 的功能。它整合了 Unsloth 開源專案並提供用戶友好的工作流程。以下是主要功能概覽:

主要功能:

- 任務管理: 用戶可以管理多個微調任務。

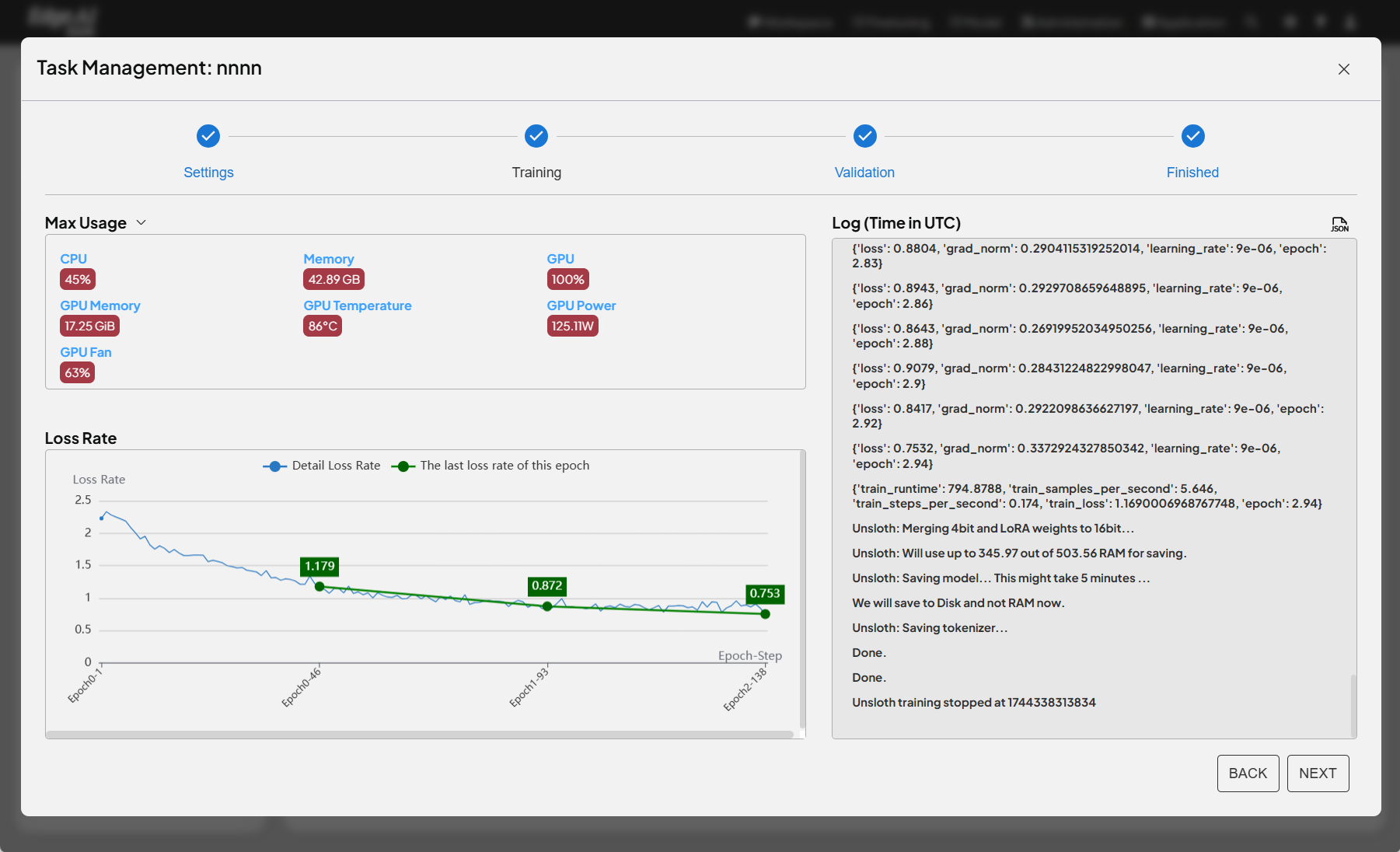

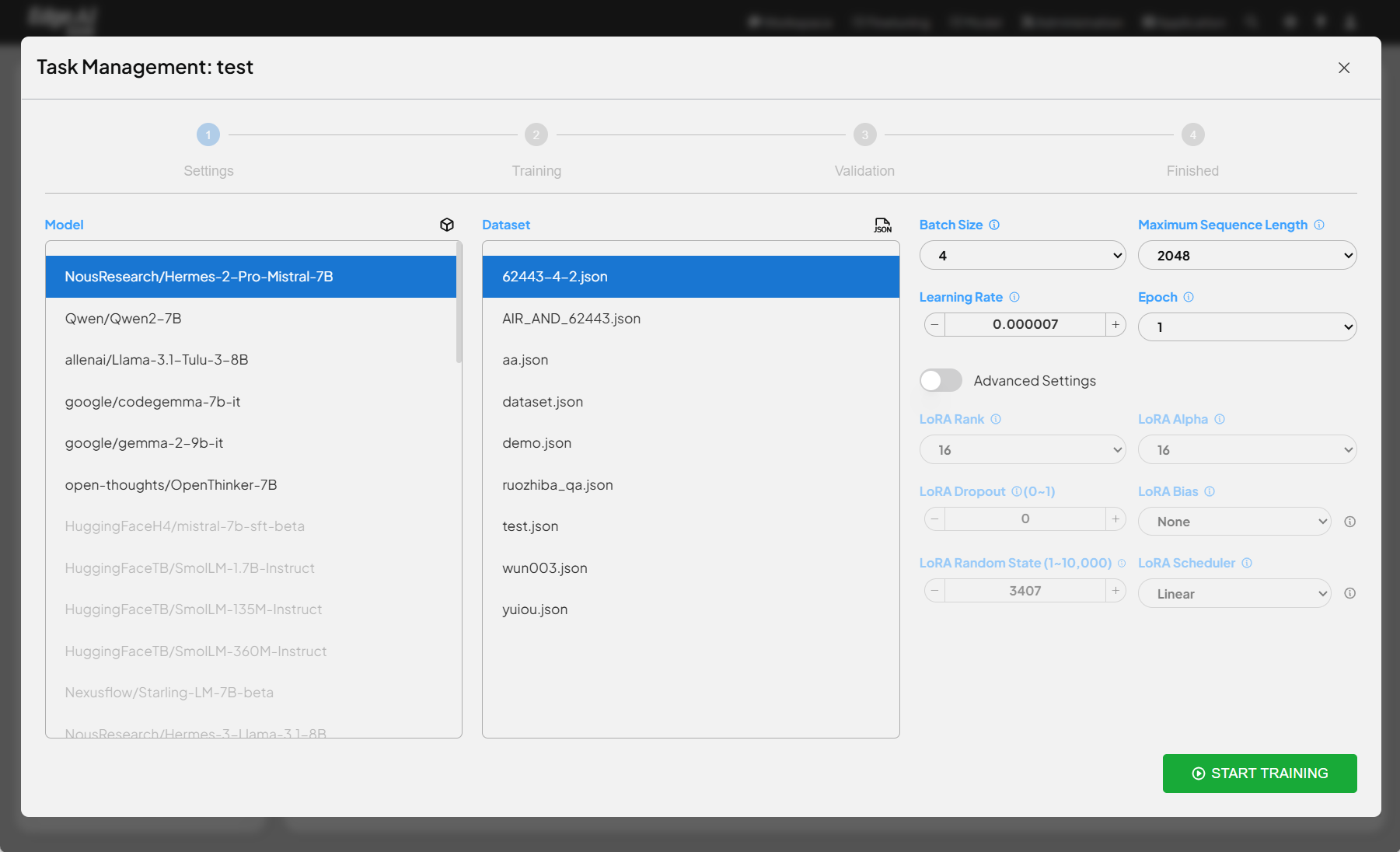

- 逐步流程: 介面提供清晰的逐步流程,包括設置、訓練、驗證和完成,以引導用戶完成微調程序。

- 模型選擇: 用戶可以從下拉選單中選擇要微調的 LLM。

- 資料集選擇: 用戶可以選擇用於微調的資料集。

- 訓練參數配置: 用戶可以配置各種訓練參數,如批次大小、最大序列長度、學習率和訓練週期。

- LoRA 配置: 用戶可以配置 LoRA 相關參數,如等級、alpha 值,以及其他高級設置,如 dropout、bias 和調度器。

- 開始訓練: 用戶可以通過點擊按鈕啟動微調過程。

- LoRA 微調: 此功能使用 LoRA 高效地微調 LLM。LoRA 是一種高效的微調技術,它凍結預訓練模型的大部分參數,只訓練少量額外參數。這顯著減少了計算和記憶體需求,同時實現與全參數微調相當的性能。

- Unsloth 整合: 該功能整合了 Unsloth,這是一個用於高效 LLM 微調的開源函式庫。Unsloth 優化了 LoRA 的實現,使其更快速、更節省記憶體。

- 與全參數微調的相似性: 使用 LoRA 的微調過程與全參數微調相似,關鍵差異在於訓練的參數。使用 LoRA 時,只有額外的 LoRA 參數被更新,而預訓練模型的參數保持不變。