轉換

模型轉換與量化

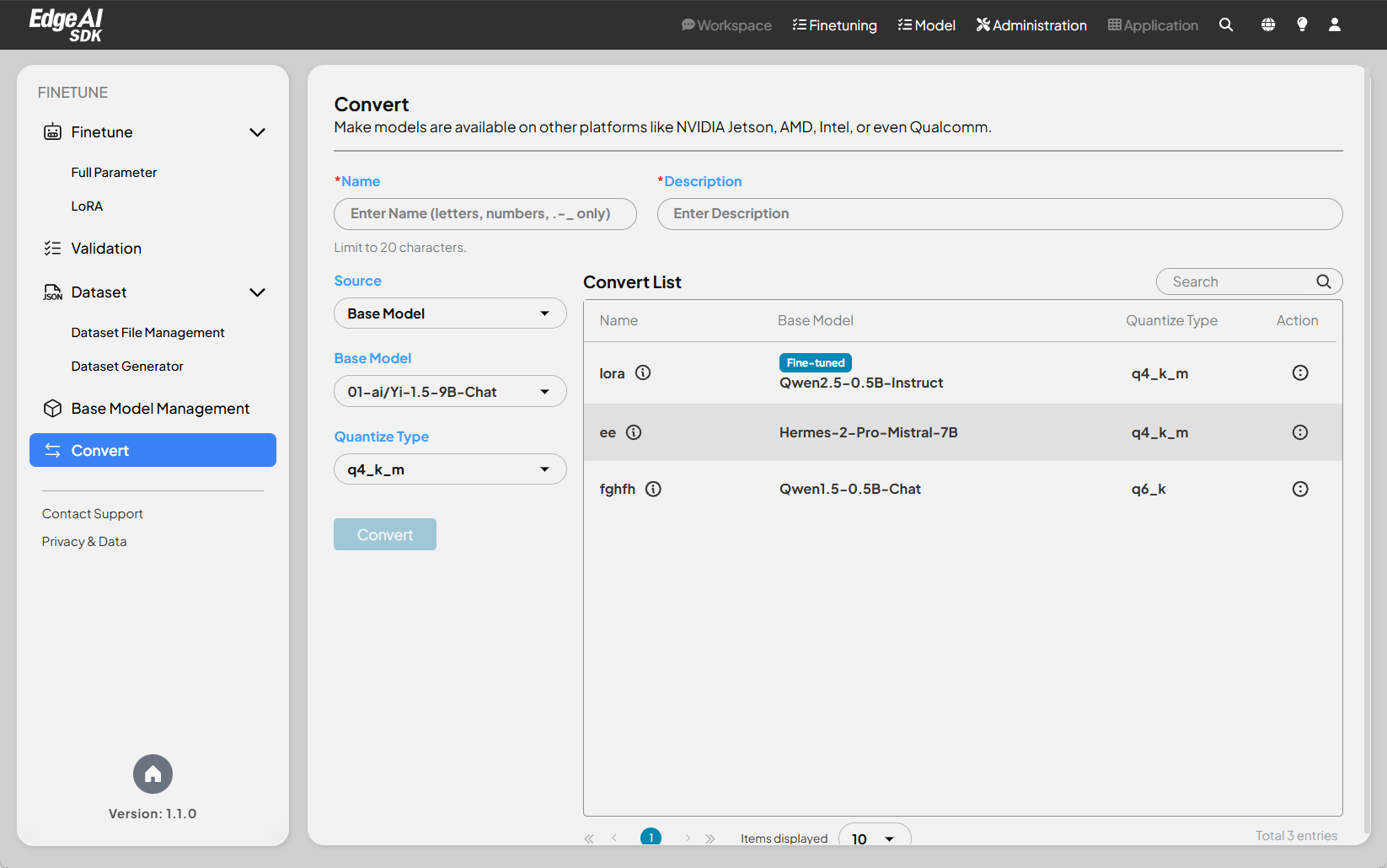

本文檔提供將大型語言模型 (LLM) 轉換和量化以部署在各種平台上的技術指導。這對於在多樣化硬體上部署和優化 LLM 至關重要,包括但不限於 NVIDIA Jetson、AMD、Intel 和 Qualcomm。本指南涵蓋基礎 LLM 和微調 LLM。

模型來源

- 基礎 LLM

- 微調 LLM

目標平台和格式

本指南涵蓋以下目標平台和格式:

- GGUF: 一種高效 CPU 執行模型的格式,特別是使用 llama.cpp 函式庫。

轉換過程

- 選擇來源模型: 從可用的基礎 LLM 或微調 LLM 中選擇。

- 模型量化:(可選)應用量化技術來減少模型大小並提高推理速度。

量化參數

量化是將模型權重從浮點數(例如 FP32)轉換為低精度格式(例如 INT8)的過程。這可以顯著減少模型大小並提高推理速度,但可能會稍微降低準確性。

常見的量化類型包括:

- q4_k_m: 一種 4 位元量化方法。

- q6_k: 一種 6 位元量化方法。

說明:

- 名稱: 輸入轉換模型的名稱(僅限字母、數字、. - _ )。

- 描述: 為模型提供可選描述(限制 20 個字元)。

- 來源模型: 從下拉選單中選擇基礎模型。

- 量化類型: 從下拉選單中選擇所需的量化類型。

- 轉換: 點擊「轉換」按鈕開始轉換過程。