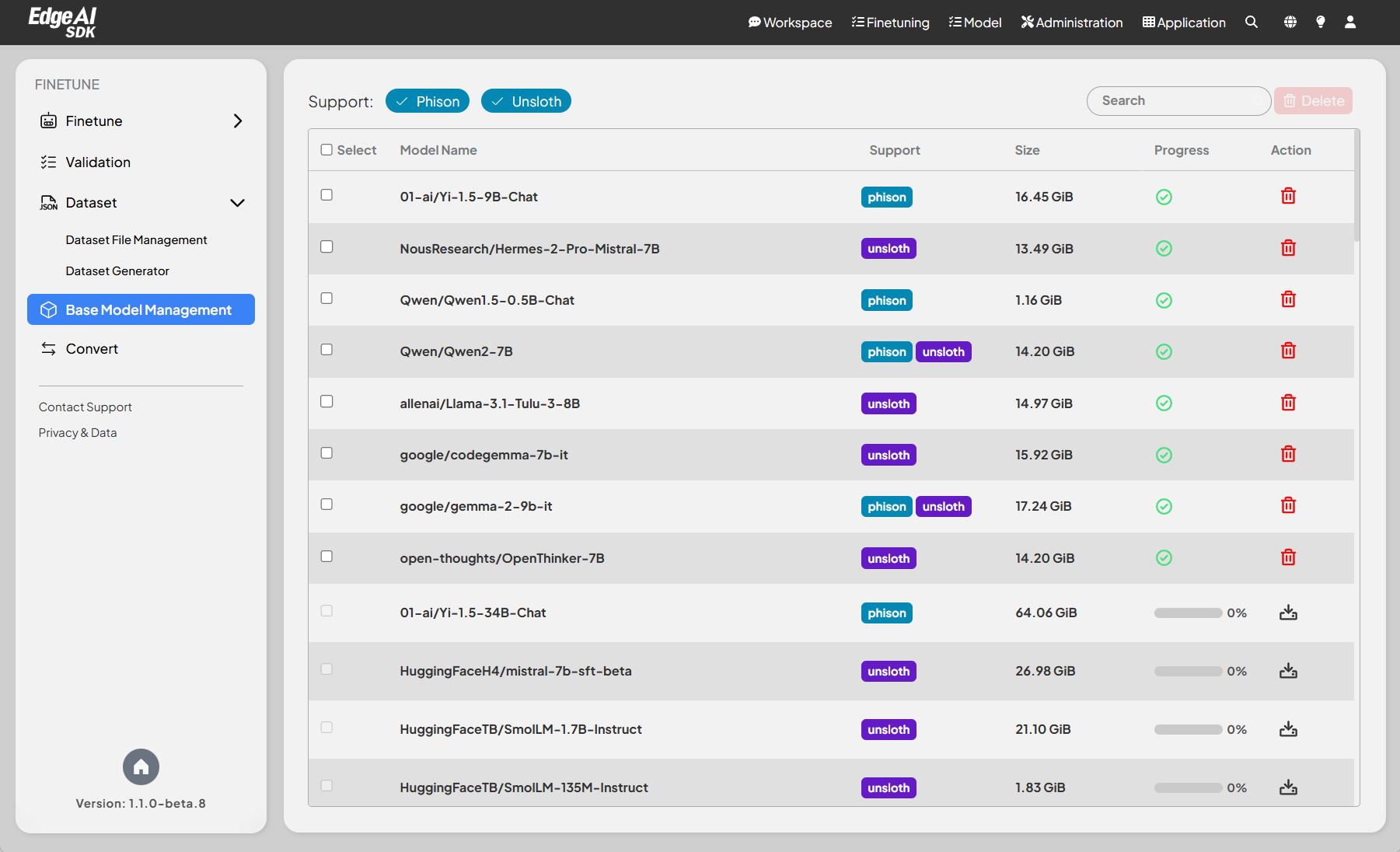

模型管理

模型管理頁面允許用戶查看和管理用於微調或推理目的的支援模型清單。模型可以直接從 Hugging Face 儲存庫下載。使用此功能前, 請確保您的設備已連接到網際網路,因為模型下載需要存取外部伺服器。

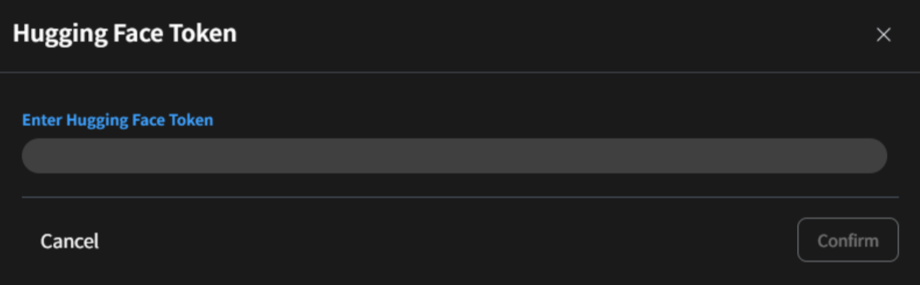

此外,在首次嘗試下載時,系統會提示用戶提供來自 Hugging Face 的 存取權杖。此權杖可以按照 Hugging Face 官方指南進行權杖生成來取得。

功能

- 模型清單:

- 顯示所有可用模型,包括其名稱、大小和當前處理狀態。

- 用戶可以使用搜尋欄搜尋特定模型。

- 模型詳細資訊:

- 模型名稱:指定模型的名稱(例如

meta-llama/Llama-3.1-8B-Instruct)。 - 支援:對全參數使用

Phison標籤,對 LoRA 機制使用Unsloth。同時標記兩者的模型支援兩種不同的 LLM 微調方法。 - 大小:顯示每個模型的儲存大小(例如 29.93 GiB、262.86 GiB)。

- 處理狀態:指示模型是否準備就緒可用(✓ 表示已就緒)。

- 操作:允許用戶管理模型(例如:下載、刪除)。

- 模型名稱:指定模型的名稱(例如

- 下載過程:

- 顯示正在獲取的模型下載進度。

- 提供模型大小和預估剩餘時間的清楚指示。

- 支援中斷下載的

暫停和繼續功能。

- 存取權杖要求:

- 在初次下載期間,用戶需要提供 Hugging Face

存取權杖進行身份驗證。

- 要生成權杖,請造訪 Hugging Face 網站並按照官方說明創建和檢索您的個人權杖。

- 在初次下載期間,用戶需要提供 Hugging Face

支援的模型

- v1.2.0

- v1.1.2

- v1.0.0

- 全參數(Phison 支援)

| 模型系統 | 模型 |

|---|---|

| Deepseek-ai | DeepSeek-R1-Distill-Llama-70B |

| DeepSeek-R1-Distill-Qwen-32B | |

| deepseek-llm-7b-chat | |

| gemma-3-27b-it | |

| gemma-3-1b-it | |

| gemma-2-9b-it | |

| Meta-llama | Llama-3.3-70B-Instruct |

| Llama-3.2-3B-Instruct | |

| Llama-3.1-405B-Instruct | |

| Llama-3.1-8B-Instruct | |

| Llama-3-Taiwan-70B-Instruct | |

| Microsoft | Phi-4-reasoning |

| phi-4 | |

| Phi-3.5-mini-instruct | |

| Mistral | Mistral-Small-3.1-24B-Instruct-2503 |

| Mixtral-8x22B-Instruct-v0.1 | |

| Mixtral-8x7B-Instruct-v0.1 | |

| Qwen | Qwen3-32B |

| Qwen3-0.6B | |

| QwQ-32B | |

| Qwen2.5-72B-Instruct | |

| Qwen2-7B |

- LoRA(Unsloth 支援)

| 模型系列 | 模型 |

|---|---|

| Deepseek-ai | DeepSeek-R1-Distill-Llama-8B |

| DeepSeek-R1-Distill-Qwen-14B | |

| DeepSeek-R1-Distill-Qwen-1.5B | |

| DeepSeek-R1-Distill-Qwen-7B | |

| gemma-3-1b-it | |

| gemma-3-4b-it | |

| gemma-3-12b-it | |

| Meta-llama | Llama-3.1-8B-Instruct |

| Llama-3.2-1B-Instruct | |

| Llama-3.2-3B-Instruct | |

| Mistralai | Mistral-7B-Instruct-v0.3 |

| Mistral-Nemo-Instruct-2407 | |

| Qwen | Qwen3-0.6B |

| Qwen3-0.6B-Base | |

| Qwen3-1.7B | |

| Qwen3-1.7B-Base | |

| Qwen3-4B | |

| Qwen3-4B-Base | |

| Qwen3-8B | |

| Qwen3-8B-Base | |

| Qwen3-14B | |

| Qwen3-14B-Base | |

| Microsoft | Phi-3-mini-4k-instruct |

| Phi-3-medium-4k-instruct | |

| IBM-granite | granite-3.2-2b-instruct |

| granite-3.2-8b-instruct |

| 模型名稱 | 支援 | 大小 |

|---|---|---|

| google/gemma-2b-it | unsloth | 14.03 GiB |

| meta-llama/Llama-3.1-8B-Instruct | phison, unsloth | 29.93 GiB |

| 01-ai/Yi-1.5-34B-Chat | phison | 64.06 GiB |

| 01-ai/Yi-1.5-9B-Chat | phison | 16.45 GiB |

| HuggingFaceH4/mistral-7b-sft-beta | unsloth | 26.98 GiB |

| HuggingFaceTB/SmolLM-1.7B-Instruct | unsloth | 21.10 GiB |

| HuggingFaceTB/SmolLM-135M-Instruct | unsloth | 1.83 GiB |

| HuggingFaceTB/SmolLM-360M-Instruct | unsloth | 4.67 GiB |

| MediaTek-Research/Breeze-7B-Instruct-v0_1 | phison | 27.90 GiB |

| Nexusflow/Starling-LM-7B-beta | unsloth | 13.49 GiB |

| NousResearch/Hermes-2-Pro-Mistral-7B | unsloth | 13.49 GiB |

| NousResearch/Hermes-3-Llama-3.1-8B | unsloth | 14.97 GiB |

| Qwen/Qwen1.5-0.5B-Chat | phison | 1.16 GiB |

| Qwen/Qwen1.5-1.8B-Chat | phison | 3.43 GiB |

| Qwen/Qwen1.5-110B-Chat | phison | 207.16 GiB |

| Qwen/Qwen1.5-14B-Chat | phison | 26.40 GiB |

| Qwen/Qwen1.5-4B-Chat | phison | 7.37 GiB |

| Qwen/Qwen1.5-72B-Chat | phison | 134.66 GiB |

| Qwen/Qwen1.5-7B-Chat | phison | 14.39 GiB |

| Qwen/Qwen2-0.5B | unsloth | 953.29 MiB |

| Qwen/Qwen2-0.5B-Instruct | unsloth | 953.29 MiB |

| Qwen/Qwen2-1.5B | unsloth | 2.89 GiB |

| Qwen/Qwen2-1.5B-Instruct | unsloth | 2.89 GiB |

| Qwen/Qwen2-72B | phison | 135.44 GiB |

| Qwen/Qwen2-72B-Instruct | phison | 135.44 GiB |

| Qwen/Qwen2-7B | phison, unsloth | 14.20 GiB |

| Qwen/Qwen2-7B-Instruct | unsloth | 14.20 GiB |

| Qwen/Qwen2.5-0.5B-Instruct | unsloth | 953.30 MiB |

| Qwen/Qwen2.5-1.5B-Instruct | unsloth | 2.89 GiB |

| Qwen/Qwen2.5-3B-Instruct | unsloth | 5.76 GiB |

| Qwen/Qwen2.5-72B-Instruct | phison | 135.44 GiB |

| Qwen/Qwen2.5-7B-Instruct | unsloth | 14.20 GiB |

| TinyLlama/TinyLlama-1.1B-Chat-v1.0 | unsloth | 2.05 GiB |

| akjindal53244/Llama-3.1-Storm-8B | unsloth | 14.97 GiB |

| allenai/Llama-3.1-Tulu-3-8B | unsloth | 14.97 GiB |

| deepseek-ai/DeepSeek-Coder-V2-Instruct | phison | 439.11 GiB |

| deepseek-ai/DeepSeek-R1-Distill-Llama-8B | unsloth | 14.97 GiB |

| deepseek-ai/DeepSeek-R1-Distill-Qwen-1.5B | unsloth | 3.32 GiB |

| deepseek-ai/DeepSeek-R1-Distill-Qwen-7B | unsloth | 14.19 GiB |

| deepseek-ai/deepseek-llm-7b-chat | phison | 12.88 GiB |

| google/codegemma-7b-it | unsloth | 15.92 GiB |

| google/gemma-1.1-2b-it | unsloth | 4.69 GiB |

| google/gemma-1.1-7b-it | unsloth | 15.92 GiB |

| google/gemma-2-27b-it | phison | 50.74 GiB |

| google/gemma-2-9b-it | phison | 17.24 GiB |

| google/gemma-7b-it | unsloth | 47.74 GiB |

| meta-llama/Llama-2-7b-chat-hf | unsloth | 25.10 GiB |

| meta-llama/Llama-3.1-405B-Instruct | phison | 2.22 TiB |

| meta-llama/Llama-3.1-70B-Instruct | phison | 262.86 GiB |

| meta-llama/Llama-3.2-3B-Instruct | unsloth | 11.98 GiB |

| meta-llama/LlamaGuard-7b | phison | 25.11 GiB |

| meta-llama/Meta-Llama-3-70B-Instruct | phison | 262.86 GiB |

| meta-llama/Meta-Llama-3-8B-Instruct | phison, unsloth | 29.93 GiB |

| mistralai/Mistral-7B-Instruct-v0.1 | unsloth | 27.47 GiB |

| mistralai/Mistral-7B-Instruct-v0.2 | unsloth | 27.47 GiB |

| mistralai/Mistral-7B-Instruct-v0.3 | unsloth | 27.00 GiB |

| mistralai/Mixtral-8x22B-Instruct-v0.1 | phison | 261.95 GiB |

| mistralai/Mixtral-8x7B-Instruct-v0.1 | phison | 177.40 GiB |

| teknium/OpenHermes-2.5-Mistral-7B | unsloth | 26.98 GiB |

| yentinglin/Llama-3-Taiwan-70B-Instruct | phison | 31.43 GiB |

| 模型名稱 | 大小 |

|---|---|

| google/gemma-2-9b-it | 18.51 GiB |

| meta-llama/Llama-3.1-8B-Instruct | 29.93 GiB |

| meta-llama/Llama-3.1-70B-Instruct | 262.91 GiB |

| meta-llama/Llama-3.1-405B-Instruct | 2.22 TiB |

| meta-llama/Llama-2-7b-chat-hf | 25.11 GiB |

| meta-llama/Llama-2-13b-chat-hf | 48.48 GiB |

| meta-llama/Llama-2-70b-chat-hf | 256.96 GiB |

| meta-llama/Meta-Llama-3-8B-Instruct | 29.93 GiB |

| meta-llama/Meta-Llama-3-70B-Instruct | 262.91 GiB |

| yentinglin/Llama-3-Taiwan-70B-Instruct | 131.45 GiB |

| meta-llama/LlamaGuard-7b | 25.11 GiB |

| codellama/CodeLlama-7b-Instruct-hf | 25.11 GiB |

| codellama/CodeLlama-13b-Instruct-hf | 48.79 GiB |

| codellama/CodeLlama-70b-Instruct-hf | 257.09 GiB |

| mistralai/Mixtral-8x7B-Instruct-v0.1 | 177.39 GiB |

| mistralai/Mixtral-8x22B-Instruct-v0.1 | 261.99 GiB |

| taide/TAIDE-LX-7B-Chat | 12.92 GiB |

| MediaTek-Research/Breeze-7B-Instruct-v1_0 | 13.95 GiB |

| MediaTek-Research/Breeze-7B-32k-Instruct-v1_0 | 27.92 GiB |

| tiiuae/falcon-180B-chat | 334.41 GiB |

| mistralai/Mistral-7B-Instruct-v0.3 | 27.01 GiB |

| Qwen/Qwen2-7B | 14.2 GiB |

| Qwen/Qwen2-7B-Instruct | 14.2 GiB |

| Qwen/Qwen2-72B | 135.44 GiB |

| Qwen/Qwen2-72B-Instruct | 135.44 GiB |

| Qwen/Qwen1.5-0.5B-Chat | 1.16 GiB |

| Qwen/Qwen1.5-1.8B-Chat | 3.43 GiB |

| Qwen/Qwen1.5-4B-Chat | 7.37 GiB |

| Qwen/Qwen1.5-7B-Chat | 14.39 GiB |

| Qwen/Qwen1.5-14B-Chat | 26.41 GiB |

| Qwen/Qwen1.5-72B-Chat | 134.68 GiB |

| Qwen/Qwen1.5-110B-Chat | 207.14 GiB |

| deepseek-ai/deepseek-llm-7b-chat | 12.88 GiB |

| deepseek-ai/deepseek-llm-67b-chat | 125.56 GiB |

| deepseek-ai/deepseek-moe-16b-chat | 30.5 GiB |

| 01-ai/Yi-1.5-6B-Chat | 11.3 GiB |

| 01-ai/Yi-1.5-9B-Chat | 16.45 GiB |

| 01-ai/Yi-1.5-34B-Chat | 4.07 GiB |

存取權杖步驟

- 前往 Hugging Face 網站:https://huggingface.co。

- 登入您的 Hugging Face 帳戶。

- 前往您的帳戶設定並選擇 存取權杖 分頁。

- 生成一個具有所需權限的新權杖。

- 複製該權杖,並在應用程式的模型下載過程中出現提示時提供該權杖。

如需更多詳細資訊,請參閱 Hugging Face 文檔。

注意

某些模型(例如 LLAMA)在下載前需要用戶同意分享聯絡資訊。